- Finhay lừa đảo khách hàng có đúng không? tìm hiểu ứng dụng Finhay

- Cảnh báo 13 hình thức lừa đảo công nghệ cao phổ biến hiện nay

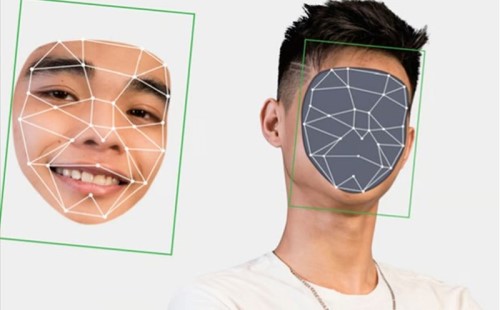

Các đối tượng sử dụng công nghệ trí tuệ nhân tạo (AI) để tạo ra những video hoặc hình ảnh giả, sao chép chân dung để tạo ra các đoạn video giả người thân, bạn bè để thực hiện các cuộc gọi lừa đảo trực tuyến. Nhiều chuyên gia công nghệ thông tin gần đây đã cảnh báo về tình trạng này

Phát sóng trực tiếp, trò chuyện khá tự nhiên nhưng lại chỉ là những hình ảnh hoàn toàn do AI tạo ra. Là một người chuyên sử dụng các ứng dụng AI cho công việc phục chế video, anh Quang nhận thấy, công nghệ này đang có sự tiến bộ vượt trội trong việc giả mạo giọng nói, gương mặt thường được gọi là Deepfake.

Anh Viên Hồng Quang Chuyên viên phục chế hình ảnh, cho biết.

“Một năm trước, tôi sử dụng để làm một đoạn phim ngắn 2 – 3 phút thì mất vài ba ngày. Nhưng Bây giờ, chỉ cần một bức ảnh hoặc một video là chúng ta có ngay một đoạn video của một nhân vật, người nổi tiếng. Chỉ cần đúng một bức ảnh và một video ở góc máy tương đương là máy sẽ tự tạo ra đoạn video đó”

Tháng 3/2019, một thư ký tại Anh nhận được cuộc gọi khẩn của Chủ tịch tập đoàn. Giọng nói cùng phong thái quen thuộc của vị CEO khiến người nhân viên này không nghi ngờ gì mà chuyển ngay số tiền 220.000 Bảng Anh, tương đương với hơn 6 tỷ đồng

Bà Marie Chistine Kragh từ Công ty Bảo hiểm Euler Hermes cho rằng:

“Chúng tôi thấy các dấu hiệu rõ ràng từ vụ lừa đảo này là có sự can thiệp của công nghệ trí tuệ nhân tạo khi làm giả giọng nói y hệt để lừa các nạn nhân”.

Tại Việt Nam, một người đàn ông đã bị lừa 20 triệu đồng khi bị đối tượng lừa đảo giả dạng khuôn mặt và giọng nói của bạn mình và yêu cầu ông chuyển tiền.

Anh Đặng Anh Quang tại quận Hai Bà Trưng, Hà Nội chia sẻ:

“Đối tượng cũng gọi video, đúng khuôn mặt đấy luôn nhưng thấy có mỗi cái miệng mấp máy thôi. Mình cứ nghĩ mạng bị lag, chỉ gọi được vài giây rồi thôi nên mình cũng tin tưởng, lúc đó cũng đang vội. Sau đó, họ nhắn số tài khoản và mình chuyển tiền thôi”.

Anh Vũ Ngọc Sơn Giám đốc kỹ thuật, Công ty Công nghệ an ninh mạng quốc gia Việt Nam cho biết:

“Video clip sinh ra từ Deepfake sẽ không có chất lượng tốt, tương đối mờ, giọng nói không rõ ràng. Nếu để ý kỹ thì người sử dụng có thể nhận thấy những nhân vật trong clip thường ít quay mặt, đưa tay lên mặt hoặc chớp mắt. Đó là những hành động mà Deepfake chưa thể làm giả 100% giống như người bình thường”.

Một nguyên tắc của Deepfake là thu thập dữ liệu từ chính hình ảnh và giọng nói của người dùng. Châu Âu và Trung Quốc hiện áp dụng các giải pháp siết chặt Deepfake, trong đó quy định chặt chẽ về việc cung cấp dữ liệu cá nhân.

Còn tại Việt Nam, người dùng cũng cần lưu ý trong việc đăng tải hình ảnh và giọng nói của mình trên không gian mạng.

Để lại bình luận

5